„Ich hätte gerne all diese Daten“

Der Linzer Mathematiker und FH-Professor Andreas Stöckl weiß, wie man Algorithmen programmiert. Der Geschäftsführer des Cyberhouse in Linz über künstliche Intelligenz und die Gefahren, die eine Änderung des Algorithmus für Facebook nach sich ziehen kann.

OÖNachrichten: Herr Stöckl, an welchem Algorithmus arbeiten Sie gerade?

Andreas Stöckl: Wie stelle mir gerade die Frage: Wie kann ich einen Fake-News Artikel detektieren. Ich mische einer Vielzahl von Reuters-Agenturmeldungen ein paar Satire-Artikel der Tagespresse oder des Postillion rein und versuche, einen Algorithmus aus der künstlichen Intelligenz zu schaffen. Das Spannende ist, kann ich einer Maschine beibringen, ob es Satire ist oder nicht, obwohl ich genau weiß, dass er nur plus und mal rechnen kann. Finde ich einen Algorithmus, der das so nachahmt, obwohl das Ding es gar nicht versteht? Wo man sagt, eigentlich dürfte er das nicht können, weil er es nicht versteht, aber ein Flugzeug fliegt nicht wie ein Vogel, aber es fliegt auch ganz gut. Nur anders. Ich habe einen Hammer in der Hand und brauche ein Werkzeug, um das auszuprobieren.

Warum bewegt sich in jüngster Zeit bei der künstlichen Intelligenz so viel?

In vergangenen fünf Jahren geht im Bereich der künstlichen Intelligenz extrem viel weiter. Facebook, Google sind Treiber davon. Vor 30 Jahren hätte man noch gesagt, das geht nie. 25 Jahre ging auch tatsächlich nichts weiter. Zwei Faktoren sind entscheidend, dass sich das jetzt geändert hat - etwa beim autonomen Autofahren: Ein Mehr an Rechenleistung und ein Mehr an Verfügbarkeit der Menge an Daten. Letzteres ist der größere Faktor.

Was bedeutet das bei Ihrem aktuellen Fake-News-Projekt?

Es geht um die Frage: Kann ich das Ding trainieren, damit es auch gut wird? Ich besorge mir also Textdaten. In diesem Moment saugt sich mein Rechner gerade 50.000 Artikel aus Reuters heraus. Es ist gar keine Hexerei dabei und immer die gleiche Herangehensweise: Man zerlegt in einzelne Bausteine. Ich zerlege das in einzelne Wörter oder Phrasen mache daraus mit Algorithmen statistische Analysen – und überlasse das dann einem machinelearning Algorithmus. Das Ding versucht dann selbständig Muster zu erkennen. Als Menschen können wir das vielleicht gar nicht erkennen oder verstehen. Das Ding unterscheidet dann für sich: Die Falschnachricht hat eine längere Wortanzahl, kürzere Sätze und so weiter. Diese Dinge gebe ich dem Algorithmus nicht vor, ich gebe ihm nur eine gewisse mathematische Struktur vor und sage ihm: Zerleg das jetzt in Bausteine, versuch die zu bewerten und ich gebe dir 100.000 Beispiele, wo ich dir dazu sage, das ist Fake oder Nicht-Fake und lerne selbsttätig aus diesen sehr vielen Dingen Muster anzulernen. Und wenn du einen neuen Text bekommst, schau aufgrund des erlernten Fingerabdrucks, ob das passt und ordne es dann zu.

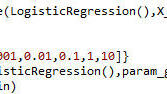

Bildtext: Ein Auszug eines Algorithmus in der Programmiersprache Python von Andreas Stöckl

Gibts schon erste Erkenntnisse?

Heute Nacht habe ich einen ersten Versuch gemacht. Mehr als 90 Prozent hat er richtig erraten.

Ein kluger Kerl, Ihr Computer.

Man muss mit solchen Ergebnissen extrem vorsichtig sein: Ich trainiere ihn ja mit vielen Daten. Oft glaubt man, man ist schon sehr weit. Und dann gibt es Rückschritte, wenn neue Quellen dazukommen und man ihm was falsch angelernt hat. Beim Postillion sind die Artikel am Ende mit drei Buchstaben als Redaktionskürzel gekennzeichnet. Die gebe ich sofort in der Datenbereinigung heraus, weil er das sofort erkennen würde. Er hätte dann also nicht den Artikel selbst als Fake News erkannt sondern über das Redaktionskürzel. Er muss es aber so erkennen. Ein anderes Beispiel: Man könnte einen Computer darauf trainieren, dass er Hunde- und Katzenfotos voneinander unterscheiden kann.

Wo sind da die Sollbruchstellen?

Wenn ich etwa bei jedem Hundefoto eine Sonne im Hintergrund haben würde und bei jedem Katzenfoto keine Sonne. Das Ding würde jetzt Hunde und Katzen unterscheiden können, aber eigentlich hat er gelernt: Sonne oder Nicht-Sonne. Und das erste Foto mit Hund und Regen würde er falsch zuordnen. Man muss immer sehr kritisch prüfen, ob man bei der Datenmenge, die man hat, nicht irgendwelchen Scheindingen aufsitzt. Der große Fortschritt ist der umsichtige und schlaue Umgang mit den Daten.

Bei Facebook ändert man gerade den Algorithmus. Es sollen private Posts mehr Gewicht bekommen als jene von Unternehmen oder Medien.

Ich als Statistiker hätte wirklich gerne Einblick. Was die Daten haben, das muss gewaltig sein. So ein Änderungsprozess dauert, obwohl so viele Leute daran arbeiten. Wenn Google oder Facebook an ihrem Algorithmus ein bissl was herumschrauben und sich dann nur ein kleiner Prozentsatz an Klickzahlen oder Buchungen bei Anzeigen ändert, dann sind das ja gleich Milliarden. Wenn der Schuhhändler in Linz einen Fehler macht, hat er einen Kunden verärgert, aber bei Facebook oder Google sind wir auf einer weltweiten Skala unterwegs.